Cuando consideramos una nueva tecnología:

- Los índices de adopción o uso se mantendrán constantes pueden disminuir o aumentar.

- La tecnología que abastece nuestras necesidades energéticas podría avanzar hacia la eficiencia o cambiar en la combinación energética global.

- La eficiencia de la tecnología concreta que se adopte podría cambiar, hemos visto numerosos ejemplos en los que una versión inicial de algo en tecnología o software se enfrenta a mejoras posteriores que pueden dotarla de mayores capacidades con un menor consumo de energía.

Incluso la propia inteligencia artificial (IA) podría sugerir mejoras de la eficiencia energética para aplicaciones específicas, como la calefacción y refrigeración de un edificio. Por lo tanto, cualquier análisis del uso de la energía y la IA debe reconocer que la única constante será el cambio.

Impacto ambiental de los modelos lingüísticos de gran tamaño (LLM) seleccionados

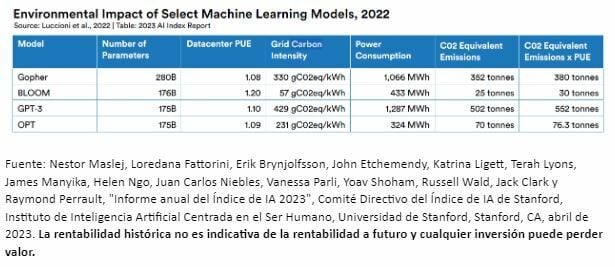

Los modelos lingüísticos de gran tamaño han acaparado la mayor parte del interés que ha suscitado la IA generativa. Hay que tener en cuenta la cantidad de emisiones de carbono que generan algunos de estos sistemas. El informe de Standford sobre el índice de IA (Stanford AI Index Report), publicado en 2023, aportó algunos datos, señalando que factores como el número de parámetros de un modelo, la eficacia del uso de la energía de un centro de datos y la intensidad de carbono de la red son importantes.

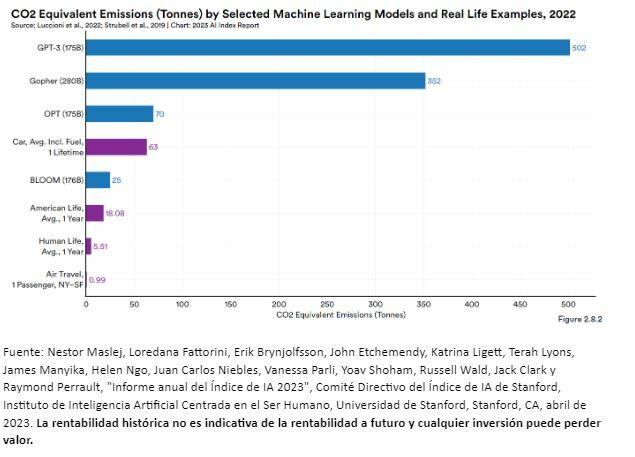

Los gráficos 1a y 1b ofrecen más detalles sobre la intensidad del dióxido de carbono en los distintos LLMs:

- Hay múltiples factores que influyen en el resultado: en el gráfico 1a, "Número de parámetros" podría dar a entender que un mayor número de parámetros siempre implica más emisiones, pero no siempre es así. En elcaso de Gopher, con 280.000 millones de parámetros, no tiene las emisiones equivalentes de dióxido de carbono más elevadas x PUE, sino que fue GPT-3.

- GPT-3, aunque no es el modelo más grande por número de parámetros, se utilizó con una intensidad de carbono de red que fue la más elevada de los modelos mostrados y tuvo el mayor consumo de energía de todos ellos. A pesar de esto, es instructiva porque nos obliga a pensar no solo en el número de parámetros, sino también en dónde se encuentra el centro de datos en el que se produce el entrenamiento, cuál es la intensidad de la red de emisiones de carbono en la que se asienta el centro de datos y cuál es el consumo de energía del modelo.

- El gráfico 1b está diseñado para ayudar a tomar una actividad relativamente abstracta (la de entrenar a un LLM) y relacionar las emisiones de carbono resultantes con actividades más concretas, como viajar de Nueva York a San Francisco en un vuelo. Ver que GPT-3 se asocia con 502 toneladas de emisiones equivalentes de dióxido de carbono ayuda a darnos un sentido de su escala.

Gráfico 1a: Impacto ambiental de los modelos de aprendizaje automático seleccionados, 2022

Gráfico 1b: Emisiones equivalentes de dióxido de carbono (toneladas) por modelos de aprendizaje automático seleccionados y ejemplos reales

Considerando el consumo de energía de un LLM

Quienes crean diferentes LLM disponen de muchas posibilidades para modificar las distintas características, como el consumo de energía. Los investigadores de Google propusieron una familia de modelos lingüísticos denominada GLaM (Modelo Generalista de Lenguaje), que utiliza una "mezcla de expertos de activación dispersa". El mayor de los modelos GLaM tiene 1,2 billones de parámetros, por lo que podría pensarse que este modelo consumiría más energía que cualquiera de los modelos que vimos en los gráficos 1a o 1b.

En realidad, el modelo GLaM con 1,2 billones de parámetros consume solo un tercio de la energía necesaria para entrenar GPT-3 y requiere solo la mitad de operaciones de coma flotante por segundo (FLOPS) para las operaciones de inferencia. Una forma sencilla de entender lo que ocurre es que, aunque el modelo total tiene 1,2 billones de parámetros, un token de entrada determinado en el modelo GLaM solo activa un máximo de 95.000 millones de parámetros, es decir, el modelo completo no está activo en todos los parámetros. GPT-3, por su parte, activó los 175.000 millones de parámetros en cada ficha de entrada. Aunque la medición del rendimiento de los modelos de IA se produce en muchas dimensiones, en muchas mediciones el modelo GLaM también es capaz de superar al GPT-3.

Conclusión

El diseño de los modelos importa, y los diseñadores de modelos que busquen desarrollar nuevas formas de mantener el rendimiento, pero consumiendo menos energía, tienen muchas opciones.